スマホ文化はどんな進化を遂げる?

司会者:お待たせいたしました。ただ今より、S1−4「次の5年のスマホ活用の文化・広がりを俯瞰する」と題し、フリーランスジャーナリスト・コンサルタント、林信行様よりご講演いただきます。それでは、よろしくお願いいたします。

林信行氏:みなさん、こんばんは。これから40分ほどお付き合いいただければと思います。ちょっとわかりにくいタイトルなんですけれど(笑)。

今日、SoftBank World、朝から参加されている方もいっぱいいらっしゃって、今、大きく時代が、人工知能やIoT、そういったものに流れているということを感じていただいたと思います。

これからの私のセッションでは、この人工知能やIoTといったものが、みなさんのポケットに入っているiPhoneやAndroidといったスマートフォンとどう関わってくるのか。そのあたりの話をしようと思っています。

私も、今年でテクノロジー業界の取材を始めて26年目になるんですけれど、歳のせいなのか、最近はよく考えれば考えるほど、昔に未来のヒントがあるのを感じたりします。

今年はもう1個、話題のキーワードでいうと、VRも話題ですよね。実はVRの研究も、もう数十年前から、MITのメディアラボとか、そういうところで行われているものでした。

今って、人工知能にしても、IoTにしても、非常に激しい競争のなかでやっているので、性急に製品を出さなければいけないというかたちで、みなさん、短期間のあいだで商品化していくものが多いんですけれど、90年代とか80年代は、もうちょっと時間があって、世界のトップレベルの研究者たちがけっこうおもしろい未来のことを考えていたりします。

「Knowledge Navigator」が夢見た未来

みなさんも今日、一番最後のセッションまで出ていただいて、お疲れだと思うんですね。ちょっと気を楽にしながら、Appleが1987年頃に作っていた「Knowledge Navigator」というビデオを最初にお見せしようと思います。

Knowledge Navigatorを、ご存知の方ってどれぐらいいらっしゃいますか?

(会場挙手)

ちらほら、1割に満たないぐらいはいらっしゃいますね。もうすでにご存知の方はすみませんが、お付き合いいただければと思います。では、お見せします。

(Knowledge Navigatorの紹介動画が流れる)

これはYouTubeなどで見ていただくとして、このKnowledge Navigator、言ってみれば、今から30年前のiPadですよね。

実際のiPad、この30年の隔たりによって、なにが変わったかというと、カメラがあんなに大きくゴツくなくてもいいってことはもちろんなんですけれど、上でPhilという名前の人が出てきて話をしていましたけれど、ああいった偽の人格の顔まではいらないということがありますね。そういったものがなく、今、Appleの「Siri」というiPhone、iPadの機能では、顔が出てこずに声だけが出てくるというかたちで実装されています。

今のビデオを思い出してほしいんですけれど、一番最初にPhilがこう言います。「メッセージが3件あります。先生の研究員がグアテマラから連絡してきました」。今、先生に伝えるべき内容を教えてくれるんですけれど。

これってよく考えると、すでにiPhoneで実行されている「通知」という機能、Androidにもありますけれど、これにほかなりません。

みなさん、「通知」というのは、iPhoneがブルっと震えて、画面を見たときにしか気がついてないかもしれませんけれど、今、Siriを起動して「通知を読み上げて」と言うと、もうちゃんと声で返してくれます。なので、この部分はすでに現実になっています。

「Siri」が可能にしたこと

あるいは、次にはこのPhilが「今日の12時に学部内の昼食会があります」とか、スケジュールを言ってくれました。

これも実は、iPhoneで通知を上からピッて出してきて、その横の「今日」というところをタップすると、今日の予定が出てくるようになっています。

iPhoneのSiriに向かって、「今日の最初の予定は?」と聞けば、「今日の一番最初の予定は、朝9時から電話インタビューです」とか、こういうふうに教えてくれるようになっています。

そして途中、先生が論文を探していて、まだ読んでいない新しい論文を出してくれってことを、このKnowledge Navigatorに言っていました。

これもまったくほぼ同じようなことが、例えば今、iPhoneのSiriに向かって「未読のメールを表示して」と言うと、いっぱい受信しているメールのなかから未読のメールだけを選別して表示してくれます。

実はこのKnowledge Navigator、30年前のAppleのiPadの未来のビジョンは、今日、現実のものになりつつあります。

Siri、使っていますか?

ここでもうひとつみなさんに聞きたいんですけれど、Siri、いったいみなさんはどれだけ使ってらっしゃいますか?

これは今年出る「iOS 10」の話ではなくて、今現在のSiriでも、もうすでに賢いことが起きています。

ただ、やはり今はあまりにも毎年いろんな機能が発表されるので、それを使いこなせていないという、そこがうまくいってない部分があると思うんです。

例えば、僕はけっこうSiriを使う人間なのですが、iPhoneに向かって「渋谷で撮った写真を見せて」って言うと、何万枚とある、僕のiPhoneのなかの世界中のあちこちで撮った写真のなかから、渋谷で撮った写真だけを選別して表示してくれます。

もし渋谷で撮った写真がたくさんありすぎる場合は、「先月、渋谷で撮った写真だけを表示して」と言うと、先月のものだけをそのなかから表示してくれます。これは今、みなさんのポケットに入っているiPhoneでできる機能です。

あるいは、夕陽を撮りたい時には「今日の日没、何時?」と聞くと、これを実は今日の深夜にやったんですけれど、「今日の日没は18時54分」だそうです。

「今、パリは何時?」と聞くと、日本時間の深夜1時はパリの夕方6時だということがわかったり。

海外の出張中、今、ソフトバンクも定額プランで海外で使えるので「32ユーロって何円だろう?」とSiriに聞けば、実はSiriが「今日のレートで3,756円です」ということを教えてくれます。Siriって、これだけ賢いんですね。

これ以外にも、例えば今、「家を出たら『郵便局に寄る』とリマインドして」と言うと、Siriがリマインダー機能と連携します。

自宅をちゃんと住所録に登録したりする必要があるんですけれど、自宅の位置から、自分の今の現在地のGPSの位置がズレると「郵便局に寄るように」と通知してくれたりします。

本当にKnowledge Navigatorのようなビジョンが、今、現実になっています。

音声操作でこんなことまでできる

もちろん声でのやり取りができるということが、Siriの一番の特徴なので、例えば「最初のメッセージを読み上げて」と言うと、声でメッセージを読み上げてくれます。

メッセージの受信なんて、「手元にiPhoneがあるんだから、それで読めばいいじゃないか」と思う方もいらっしゃるかもしれませんけれど、実は今、iPhoneには「CarPlay」という技術があって、CarPlayに対応している車であれば、フェラーリだろうと、ホンダであろうと、ベンツであろうと、iPhoneの画面が車のダッシュボードのところに出てきます。

CarPlay対応の車は、ハンドルの部分にSiriを呼び出すボタンがついているので、それを押して「最初のメッセージを読み上げて」と言うと、一切画面を見ずに、指1本の操作だけで声でメッセージを読み上げてくれることもできれば、返信することもできたりしてしまいます。

今、ここで紹介したやりとりは、全部、今のiOSでできていることなんです。そもそもこんな音声操作を「道なかでiPhoneに向かって話しかけていたらおかしいよ」「本当に音声操作ってそんなに重要なのか?」と思う人も、まだまだいるかもしれません。

でも、例えば、目が不自由な方にとっては非常に重要な操作だったりしますよね。それだけじゃなく、目が見える人にとっても、実は非常に助かる場面がいっぱいあります。

例えば、私はよく打ち合わせとかで帰りが遅くなった時に「嫁のiPhoneに『今、帰宅中』とメッセージを送って」、こういうふうに言います。

そうすると、勝手にメッセンジャーが立ち上がって、うちの妻宛てに、ここで“妻”と言わずに“嫁”と言っているのは、妻と言うとたまに“須磨さん”にメッセージを送っちゃうことがあるので、嫁って言うんですけれど(笑)。

これを、まったく同じ操作をタッチ操作でやろうとするとどういうことになるか、みなさんも想像してほしいんです。

煩わしい操作を一発で

まず、ホーム画面を押して、今起動しているアプリを1回終了しますよね。そして、メッセンジャーを立ち上げます。

次に、「よめ」って書いちゃいましたけれど、自分の奥さんの宛先を呼び出して、そうすると、自動的に連絡帳から電話番号が入るんですけれど、続いてメッセージをフリック入力で入れる。

実は3ステップもあって、すごく大変ですよね。Siriを使えば、これが一発の操作で入ってしまいます。

実は音声操作というのは、ゴール、自分がやりたいと思っている目的を、一気に達成できてしまう。

それに対して、パソコンのマウス操作やタッチ操作は、OSのほうで用意されている「アプリ起動」とか「検索」とか「メッセージを打ち込み」といったすごく細かいステップを、いちいち1個1個逐次でやっていかなければいけなくて、けっこうめんどくさかったりします。

このSiriを使っているOSが、今日はAndroidの話よりiOSの話がメインになってしまいますけれど、この秋以降、どう進化していくのか?

「iOS 10」の登場でどう変わる?

実はAppleはこの秋に「iOS 10」という、iPhoneが登場して10番目のOSを発表します。10番目というだけあって、非常に大きな変化があります。

これまではAppleのiOSの専用の、なかに最初から入っているアプリしか操作できなかったSiriが、ついに「SiriKit」という名前で一般のほかの開発者の方にも開放されます。

なんのアプリでもSiriで操作できるというわけではないんですけれど、最初はメッセージ系のアプリ。それからVoIP系のアプリ。

メッセージ系というのは、例えばLINEとかWhatsAppとかありますよね。そういったものが、「Apple標準の『メッセージ』じゃなくて、私はどうしてもLINEで送りたいんだ」って方が、「うちの妻にLINEでメッセージを送る」と言えば、LINEのアプリがパッと起動して、メッセージを送れる。

あるいはVoIPは、例えばSkypeのようなアプリ、そういったものも対応してきます。

そして、決済。これはなにかというと、例えば、僕が中山さんに飲み会で2,000円を借りてしまった場合に、「中山さんに今、2,000円をメッセージで送る」と言うと、音声だけではさすがに不安なので1回承認のプロセスがあるんですけれど、自分のお金を人に送ることも声でできるようになります。

あるいは、送迎手配というのはなにかというと、日本だと日本交通さんとかいろいろがんばっていますけれど、海外だとUberがありますよね。タクシーみたいなものを手配して、現在地からどこかに送ってもらうサービス。これの呼び出しも「Uberの車を呼んで」とSiriに言えば、呼べるようになります。

それから、写真検索。さっき「渋谷の先月の写真を……」というのをSiriで検索していると話ましたけれど、これがAppleの標準の写真アプリだけでなく、例えばPinterestのような画像を扱うサービスで「赤系のカーペットを探している」と言うと、見つけられるようになる。そういったことがあります。

一番最後の「ワークアウト」はなにかというと、ジョギングのためのアプリとか、ヨガのトレーニングのアプリなどがiPhoneにたくさんあるんですけれど、これまではヨガマットを敷いて、ヨガのトレーニングアプリを起動した時に、いちいちスタートボタンを押しにヨガマットを離れなければいけなかったのが、iOS 10が出てくると、声で「Hey, Siri、ワークアウト開始」と言うと、スタートする。こういうふうに進化してきます。

Apple版人工知能「Siri intelligence」

これまでiPhoneでSiriというと、どうしても音声操作というイメージが強かったんですけれども、実はiOS 10以降「Siri intelligence」、いわゆるApple版の人工知能ですね。これが音声操作以外にも広がっていきます。

次の行動をSiriが予測して先回り

例えば、アプリ予想と書いてありますけれど、各アプリの開発者の人が「この人は自宅の近くにいるときにはこういうアプリをよく使う」とか、そういったことをちゃんとプログラミングして設計しておけば、SearchのSpotlightという機能があるんですけれど、これをやった時に、「この人が今、起動したアプリはこれじゃないか」という予想のところに、そのアプリのアイコンが出てくるようになります。なので、簡単に1タッチで起動できるようになります。

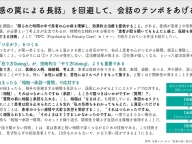

あとは、「返信予想」というのがありますけれど、英語で申し訳ないんですけれど、左側は「Thanks for letting me know. Where are you?」(あなた、今どこにいるの?)って聞いていますよね。

薄くて見えづらいかもしれませんけれども、「Current Location」と書いてあって、GPSのマークが描いてあります。

実はSiri intelligenceがメッセージのやり取り、チャットのやり取りをすでに解析していて、「Where are you?」(あなたどこにいるの?)と聞かれたら、今の自分の現在地を、「Current Location」の情報のところを指でピッと触れば、GPSを使って「今、芝公園にいる」ってことを地図付きで送れる、こういった機能が入ります。

あともう1個、よくあるやりとりとして、右側に「Do you have John's email?」って書いてありますよね。John's emailを聞かれたということは、相手が自分のアドレス帳のなかからJohnのEメールアドレスを知りたいんだということを、Siriが認識してくれて、下側に、John BishopとJohn Loftus、2人の電子メールアドレスが出ています。

相手の前後の文脈を読み取って、ピッとJohn Loftusのほうを送ると、Eメールアドレスが、一切文字を打ち込まないで、自動的に返信される。こういったSiri intelligenceも、iOS 10で入ってきます。

あるいは「文脈予測」と書きましたけれど、よくやり取りするのは、メッセージで「今度、飲茶いかない? 日曜日11時」。そういうやり取りがあると思います。こういった文意をSiri intelligenceが理解してくれて、勝手にカレンダーの新規項目を作ってくれる。こういった機能も、iOS 10で入ってきます。

メッセージ以外にも可能性は無限大

実際、メッセージのやり取りとか、どういったSiriのintelligenceが入ってくるかという、こういうリストをあげました。

文章全体を見て、今「The Orioles are playing in the ...…」と書いてありますね。すると、たぶん次は野球の球場なのか、あるいはプレイオフのなにかゲームなのか、そういった単語が来るだろうということを予測して、次の単語を候補として表示してくれる。

こういった日本語だとよくやっている予測変換の機能も、英語のキーボードでも利用できるようになります。「現在地を聞いているんだ」ということを理解して、自動入力できるようになったり。連絡先を聞かれた場合に、それを自動で返信したり。

あるいは、スケジュールを認識して登録したり。「今度の水曜日、空いている?」ということを聞かれたら、カレンダーで空いている・空いてないということを自動的に探してきて、一発で答えられるようになったり。

最近使った住所を入力したり。なにか簡単なことを聞かれたら、検索してすぐ答えがわかるようなことだったら、簡単に1タップで答えられる。こういったいろんな機能が、Siri intelligenceとして搭載されてきます。

ちなみに、こういったメールとかメッセージのやり取りにintelligenceを組み込んでいるのは、もちろんAppleだけじゃなくて、もっと先を行っているのはGoogleです。

もしかしたら、みなさん、Androidを使っている方は、標準のGmailのアプリを使っているかもしれませんけれど、GoogleはInboxという、もう1個、もうちょっと先進的なメールアプリも出しているんですね。

このInboxを使ってもらうと、今のところは残念ながら英語のメールだけなんですけれど、今、メールが来ていますよね。そうすると、たぶんこの人は次に「What do you think?」とか「Thoughts?」とか、こういったメッセージを返すだろうということを、ビッグデータから想像して、あらかじめ答えを用意してくれます。

実はGoogle、この機能を実験的に今1年ほどやっているんですけれど、今、スマートフォンからInboxを使っている人は、10パーセントの割合で、こっちを使って返答を入力しているそうです。

もちろん、これで文章を全部入力できてしまうわけではないんですけれども。最初のきっかけが1タップでできちゃうと、非常にそのあとの文章も入力しやすいということで、返答率が上がったなんてことも、Googleさんはおっしゃっていたりします。