PR

PR2024.12.24

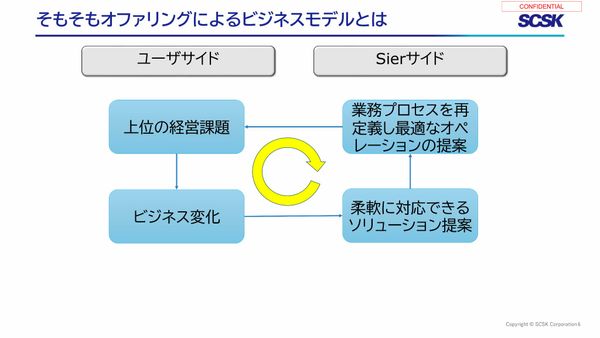

「経営陣が見たい数字」が見えない状況からの脱却法 経営課題を解決に導く、オファリングサービスの特長

リンクをコピー

記事をブックマーク

孫正義氏:GPTはいろんな言葉、これをトークンと呼びますけれども、圧倒的な数のトークン・言葉に「この言葉とあの言葉は近しい」と、関係性の近しい度合いにそれぞれ全部ベクトルのインデックスを付けて、それを処理して、言葉と言葉の数珠つなぎをして理解をするということなんです。

質問をしてChatGPTが答えてくれるんですが、理解もしているみたいだと。でも、考えているんだろうかというと、考えているかのように見えるんですが、言葉の数珠つなぎですから、必ずしもChatGPTは考えているわけではなかったということであります。

今日のメインテーマは「考える」です。圧倒的な進化がありました。先週から世に見えてきました。この「考える」ということは、Reasoningという手法で考えることなんですが、ここで聞きたいと思います。

Reasoningをする、考えるという機能を使ったことがあるか。僕は毎日使っているんですが、今日も朝から使ってきました。これを「自分はやっています」と自信を持って言える方、手を挙げてください。あれ? いませんね。

じゃあ、何かということをお話しします。OpenAIが先週からo1-previewを発表して、previewに触ることができます。この中で、ChatGPTの有料版にサブスクリプションして、毎日のように使っているという方は手を挙げてください。

あ、これはかなり使っていますよね。半分以上、7割ぐらい使っています。日本では、まだ7割の浸透率はないです。でも、さすがにSoftBank Worldですからね。今日来ている人は一般の人より進んだ方々であります。

進んだみなさんも、o1をまだ使ったことがない人がほとんどでした。o1とChatGPTの4oの違いは何か、仕組みでわかっている方は手を挙げてみてください。ゼロ人ですか。これはヤバい。ヤバいということです。

ゼロ人ということはみなさん知らない。まぁ1人ぐらい、もしかしたら恥ずかしくて手を挙げられなかったかもしれませんね。「自信を持って」というキーワードがありましたから(笑)。これを今日は僕がみなさんに解説いたします。

すごいんです。僕はこれ(o1)はノーベル賞ものだと思いますね。サーチ、検索エンジンは「知る」ということでした。ChatGPTのGPTはPre-Trainingで、「理解する」ということでした。今回のo1はGPTの頭文字が付いていないんです。

Pre-Trainingじゃないんです。事前学習のPre-Trainingとは違うんです。だからGPTという3文字が付いていないんです。o1は、まったく新しいモデルとしてもう1回再定義するということです。それでネーミングがo1になっているんですね。

このo1の仕組みの説明を今日は申し上げたいと思いますが、その前に結果を申し上げましょう。o1になってGPT-4oからどのくらい進化したかということであります。GPT-4oに博士号レベルの物理、化学、生物とか、これらの問題を解かせると何パーセントぐらい解けるか。

これは、かなり難しい内容のものですよ。恐らくここにいるみなさんは、ほぼ全員正解を出せないぐらいのレベルです。博士号レベルですからね。専門家というのは、ここで言う博士号レベル、PhD(レベル)の試験で、GPT-4oは56パーセントの正解率でした。人間の博士(70パーセント)のほうが正解率は高かったんですね。

しかし今回のo1はなんと(正解率が)78パーセントで、人間の博士号レベルを初めて超えたんです。他のモデルは超えていないんです。各社いろんなモデルがありますが、このo1が初めて超えた。

じゃあ数学はどうかというと、数学はさっき言ったように、必ずしも内容を考えているというレベルではなかったので、数学は考えなきゃいけないんですね。4oでやると13パーセントの正解率だったんです。今回のo1は、なんと83パーセントです。圧倒的に違いますね。

つまり今までの生成AIは、数学的な難しい内容については実はあんまり答えられないんだと。これはChatGPTだけじゃなくて、他の各社のモデルもみな同じぐらいわからないということだったんですね。

しかし、o1は「考える」という能力を初めて持つことによって、数学の証明問題とか、博士号レベルのものをバンバン答えられる。数学者レベルのところ(問題)をバンバン答えられるようになりました。

じゃあソフトウェアのコーディングはどうでしょうか。これも考えなきゃいけないんです。考えてコーディングをするということですから、今まで最も進んでいたモデルのGPT-4oは11パーセントコーディングができた。

難解問題のコーディングですよ。難しいコーディングを11パーセントできた。今回のo1は、なんと89パーセント。圧倒的能力です。もうそんじょそこらのプログラマーはみな敵わないというレベルまで、考える能力ができたということであります。

「すごいな」ということだと思いますが、今まで検索や4oの世界は速さが大事でした。だからデータセンターを作るとかいうと、できるだけ人口がたくさん住んでいるところに、できるだけ近いところで、レイテンシー勝負。速さ勝負で競っていました。

検索の世界、あるいはChatGPTの世界では、速さはけっこう重要だったんですね。しかしo1になると、速さを自慢するんじゃなくて深さを自慢する。そういうステージが来たんですね。

今日、僕が朝5時か6時頃に入力してo1に質問をしました。毎日のように使っていて、ふだんけっこう簡単なことも聞くんですが、できるだけ深く真剣に考えさせようと思って難しい設問を投げかけました。

そしたらなんと答えるのに75秒かかったんです。「あれ? 止まっているかな」っていうぐらい、なかなか答えてくれない。今、どういうステータスを考えているかという途中ステータスが出てくるんですね。

「おお、今これを考えているのか、おお、次はここを考えているのか」と、見ていると頭を悩ませているなぁという感じなんですが、それを見ること自体がもう楽しいんですね。待たされることの喜びが出てきてしまった。つまり、相当深い内容を真剣に考えさせているということであります。

今日はどういう質問を投げかけたかというと、みなさん笑っちゃいますよ。私が1,000万円持っているとして、これを1億円にして返してほしいと。

「o1よ。お前が私のエージェントとしていろいろ行動して、コモディティ、株、為替だとか、いろんな市場にそれぞれ僕のアカウントで口座を開いて1億円にしてほしい。それを達成させるための戦略とメカニズムを具体的に述べよ」と言ったら、ウーンと悩んで75秒かかりました。

もしこれを本当にちゃんとo1が実現させてくれたら、みなさん毎日使いたいと思いませんか。じゃあ、みんなが使ったらどうなんだというと、早いもん勝ちですよ。これが本当のゴールドラッシュです。早く願望して、人より先に申し込んで、「がんばれ〜!」と言って成果を得る。知のゴールドラッシュが来たということであります。

例えば、この中に自動車メーカーの人もいると思いますが、EVの電池、バッテリーを2倍伸ばすようなものを発明してくれと言ったら、ウーンってああだこうだ(とo1が考える)。これで(発明が)できたら、エンジニアのみなさんにとっては最大の成果ですよね。みなさんの業界で競争に勝てるわけです。

ありとあらゆる産業で同じようなことができるわけですね。考える、調べるだけだったら、もうすでに世の中には知っている人ばっかりだから、調べるだけでは競争に勝てないんですね。人が知らないことを先に考えさせて、先に問題解決をしたら競争に勝つわけですね。

したがって速さがうれしいんじゃなくて、深さがうれしい。我々人間の世界でも、パッと答える人でもおっちょこちょいの(答えを出す)、これじゃあ意味ないわけです。

僕の尊敬している藤井(聡太)師匠でも、1手打つのに2時間とか考えるわけです。相当深く考えているわけです。深さに喜びがある、深さに感動があるという時代がついに来たわけです。考えるということであります。

さて、この深さですが、手法として今回o1が取り入れているのはCoT(Chain of Thought)。考える思考の深さの連鎖、三段論法みたいなもんですね。ソクラテスは人間である、人間はみな必ず死ぬ。(これが)第二段階。そうするとソクラテスは死ぬ、これが三段論法ですね。

このように、理論が深く深く深く。このo1はChain of Thoughtが100段階ぐらいまであるわけです。三段論法の3段階じゃなくて、100段階ぐらいまでいけるわけです。これがChain of Thoughtです。その段階の中では、必ずしも能力だけを問うんではなくて、例えば安全機能、セキュリティ機能、倫理機能、そういうものまで入っているんですね。

倫理ポリシーを入れておかないと、能力だけがガーッと進むと人類は破滅します。そのぐらいの能力がこれからの超知能に備わってくるわけです。そうすると、安全弁を作らなきゃいけないので、このChain of Thoughtはすごく重要なんですね。能力だけではなくて、安全面まで含めて、深い深いところにそれをちゃんと入れておくということであります。

さて、この「考える」という機能をもう1歩さらに深く解説しましょう。強化学習(Reinforcement-Training)です。強化学習の内容を知ってる方は手を挙げてください。2〜3パーセントいました。今日はビジネスマンですから、97パーセントの人は知らないということです。

強化学習というのはエージェントです。エージェントが試行錯誤するんです。「これでどうだ、あれでどうだ」というふうに、環境を見て、解決策を探索して、そしてその解決策を実行する。実行した結果をもう1回見て、良い結果が出たらエージェントに報酬が与えられるんです。

この報酬は必ずしもお金じゃないんです。エージェントにとってスコアみたいなもので、ハイスコアをどんどん上げて競っていく。ゲームの世界でいうとスコアを競っていく。これが報酬ですが、こういう行動をして、試行錯誤をしてこう考えて、そしたら上手くいったなら、報酬が与えられる。

水族館のアシカも、芸をした報酬としてお魚をあげるというと、その芸を覚える。これはある種の強化学習なんです。我々人類は、子どもの時からこの強化学習方式で脳が鍛えられてるんです。何かをやって良いことがあると、それをもう1回繰り返す。何かをやってお母さんに叱られたなら、それはペナルティ。

報酬とペナルティの差で「あ、これをすると良い」と「これをやると悪い」というかたちで、先ほど言った人間のニューロン、シナプスが強化学習されていくわけです。「これをやったら良かった」というと、シナプスがビャーッと電気的につながり、化学的につながる。良かったらどんどん繰り返し、そこのつながりがより強くなります。それが強化学習です。

このループをずっと観察しながらリワード、報酬、ペナルティを得るということの繰り返しで学習をしていくんですが、なんと最新のモデルのo1はエージェントが超並列で、この強化学習のトレーニングをバーッとやるんです。

数千のエージェントが並列で同時にどのぐらい試行錯誤するかというと、先ほど僕が言った75秒の間に、1エージェントごとに多段階で数億回、数十億回行うんです。

2,000のエージェントが並行して数十億回考える。みなさんの会社では2,000人のエンジニアが三段論法、トライ・アンド・エラーの試行錯誤を1日で数億回できますか。絶対にできないですね。固定観念にも囚われて、そこから出ていかない。だからそんなに数億回もあれだこれだと試せない。

これを2,000のエージェントが75秒の間で数十億回やってみてください。待たされる間に「うれしい!」「がんばってんなぁ」という感じですよね。

僕はそう思いながら、今日朝5時ぐらいからニコッと笑いながら、「快感だぁ〜」と。今までは待たされたらコラッと怒るんですが、なんとこの数千のエージェントが数十億回の掛け算を並列で動く。これがIT革命、チップの革命です。

先ほど言いました「報酬」というキーワードはすごく大事なんです。みなさんのほとんどがマネージメントの人ですが、会社でみなさんの部下をマネージする時も、成功したら褒め、失敗したら叱る。

単に長く働いたら良いんじゃない。褒める時に、お金のインセンティブまで含めてボーナスの査定のような報酬も付いていれば、成果を出したら報酬が来るというインセンティブ制度になると、より働くということです。AIのエージェントも、報酬のメカニズムでよりすばらしい成果、問題解決策を見出していくわけです。

累積の報酬を最大化することが、ゲームのゴールであります。このゲームのゴールを達成するのに、Q関数というものがあります。

このQ関数は、数千のエージェントが競争を数十億回やって、どのエージェントがどのやり方をしたら、一番報酬を得られたというのを記憶、学習するんです。これが強化学習で、Q関数が鍵になるわけです。

このQ関数をどんどん更新して、勝手にさらにゴールを高めていき、自分でモデルを進化させる。自分で「どんなデータが必要なんだ」と考えて。そのデータも獲得にいくので、もはや人間は自分でモデルを考える必要がなくなるんです。

この強化学習が、自ら考えて新しいモデルを進化させる。自ら考えて必要なデータを獲得しにいく。そして、どの試行錯誤をしたらQ関数を最大化できるかということを覚えながら、同じことを質問されて「良かった」というものはどんどん幹が太くなるわけです。さっきのシナプスの結束がより強くなる。

同じような質問をされて、同じような学習をして、結果が良くなれば、つながりがより強くなるんですが、同じことだけでは新たな進化はなかなかないんです。ですから探索という機能が付いてます。

この探索を、あえてちょっとへそ曲がりな角度からやってみたり、あえて別のトライアルを違う角度やってみると、Q関数の更新というかたちで「行け、もっとトライアルをせぇ」「何十億回やれ」ということで強化学習の連鎖をやっていく。

今まで知らなかった、人類が試さなかった未知の新しいトライアルをやって、たまたまそこにベストな問題解決、未知の解決策があった場合、これを発明と呼ぶんです。

2024.12.20

日本の約10倍がん患者が殺到し、病院はキャパオーバー ジャパンハートが描く医療の未来と、カンボジアに新病院を作る理由

2024.12.19

12万通りの「資格の組み合わせ」の中で厳選された60の項目 532の資格を持つ林雄次氏の新刊『資格のかけ算』の見所

PR | 2024.12.20

モンスター化したExcelが、ある日突然崩壊 昭和のガス工事会社を生まれ変わらせた、起死回生のノーコード活用術

2023.03.21

民間宇宙開発で高まる「飛行機とロケットの衝突」の危機...どうやって回避する?

2024.12.16

32歳で成績最下位から1年でトップ営業になれた理由 売るテクニックよりも大事な「あり方」

2024.12.18

「社長以外みんな儲かる給与設計」にした理由 経営者たちが語る、優秀な人材集め・会社を発展させるためのヒント

2024.12.20

「資格のかけ算」で切り開くキャリア戦略 4パターンの資格の組み合わせで自分の強みを最大化するヒント

2024.12.17

面接で「後輩を指導できなさそう」と思われる人の伝え方 歳を重ねるほど重視される経験の「ノウハウ化」

2024.12.12

会議で発言しやすくなる「心理的安全性」を高めるには ファシリテーションがうまい人の3つの条件

2024.12.17

さんまさんと『アメトーーク!』蛍原さんのファシリテーションの違い 心理的安全性を高める「存在感を消す」スタイル

2024.12.20

日本の約10倍がん患者が殺到し、病院はキャパオーバー ジャパンハートが描く医療の未来と、カンボジアに新病院を作る理由

2024.12.19

12万通りの「資格の組み合わせ」の中で厳選された60の項目 532の資格を持つ林雄次氏の新刊『資格のかけ算』の見所

PR | 2024.12.20

モンスター化したExcelが、ある日突然崩壊 昭和のガス工事会社を生まれ変わらせた、起死回生のノーコード活用術

2023.03.21

民間宇宙開発で高まる「飛行機とロケットの衝突」の危機...どうやって回避する?

2024.12.16

32歳で成績最下位から1年でトップ営業になれた理由 売るテクニックよりも大事な「あり方」

2024.12.18

「社長以外みんな儲かる給与設計」にした理由 経営者たちが語る、優秀な人材集め・会社を発展させるためのヒント

2024.12.20

「資格のかけ算」で切り開くキャリア戦略 4パターンの資格の組み合わせで自分の強みを最大化するヒント

2024.12.17

面接で「後輩を指導できなさそう」と思われる人の伝え方 歳を重ねるほど重視される経験の「ノウハウ化」

2024.12.12

会議で発言しやすくなる「心理的安全性」を高めるには ファシリテーションがうまい人の3つの条件

2024.12.17

さんまさんと『アメトーーク!』蛍原さんのファシリテーションの違い 心理的安全性を高める「存在感を消す」スタイル